于是写了个简单的python程序

#! /usr/bin/python import os import sys cmd = "cat /home/zhangj/hosts/* (专业提供视频软件下载)

grep -v BEGIN (专业提供视频软件下载)

grep -v END" def check_dc_line(): has_duplicate = False dc_set = set() for dc_line in os.popen(cmd, 'r').readlines(): dc_token = dc_line.split() dn = dc_token[0] cv = dc_token[1] dc = dn + "," + cv if dc in dc_set: print "duplicate dc found:", dc has_duplicate = True else: dc_set.add(dc) return has_duplicate if not check_dc_line(): print "no duplicate dc"

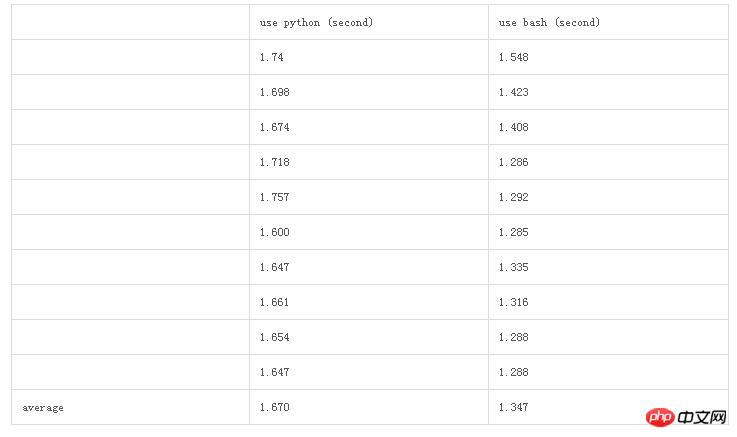

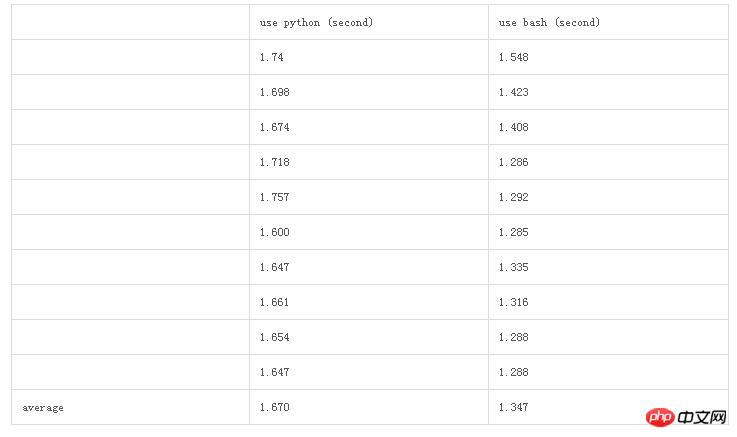

对于250个文件,共60万行的数据,过滤一遍约1.67秒

有点不甘心这个效率,于是又写了一个同样功能的shell脚本

#! /bin/bash cat /home/zhangj/hosts/* (专业提供视频软件下载)

grep -v BEGIN (专业提供视频软件下载)

grep -v END (专业提供视频软件下载)

awk ' BEGIN { has_duplicate = 0 } { dc = $1","$2; if (dc in dc_set) { print "duplicate dc found", dc has_duplicate = 1 } else { dc_set[dc] = 1 } } END { if (has_duplicate ==0) { print "no duplicate dc found" } } '

为了进一步比较,重复了10次实验。

以上就是详解小程序的python和bash版本比较的详细内容,更多请关注php中文网其它相关文章!

……